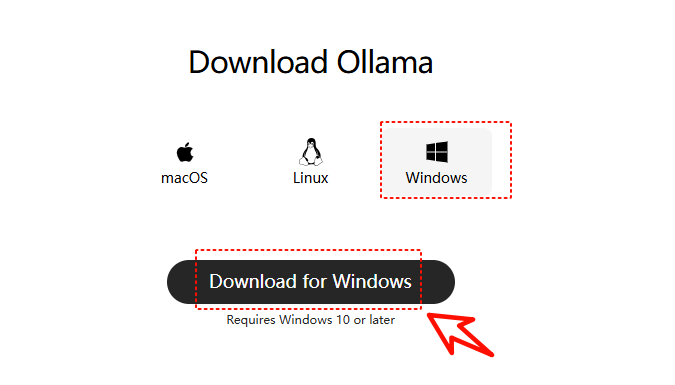

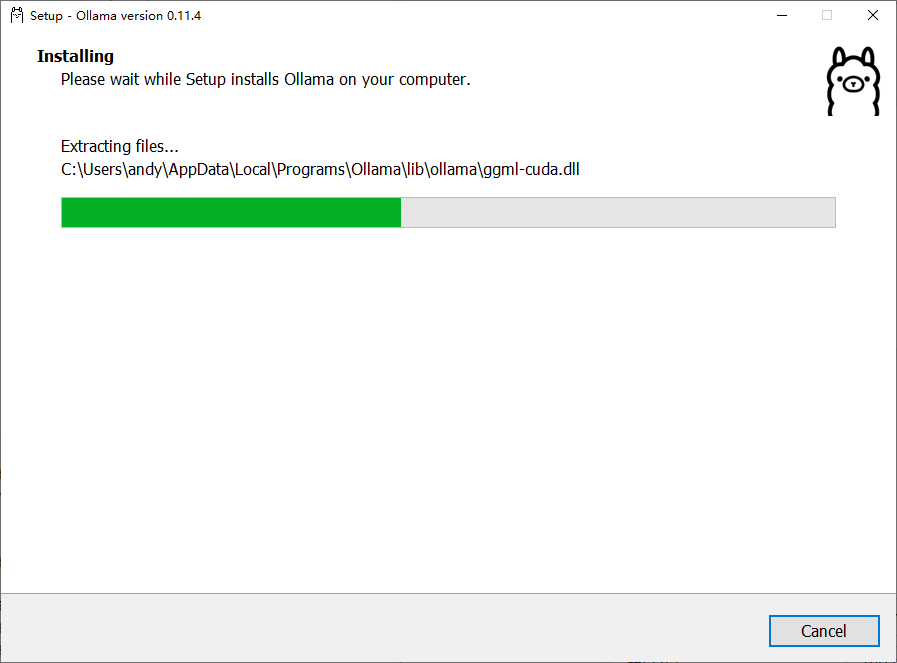

1、下载并安装

Ollama 下载:https://ollama.com/download

Ollama 官方主页:https://ollama.com

Ollama 官方 GitHub 源代码仓库:https://github.com/ollama/ollama/

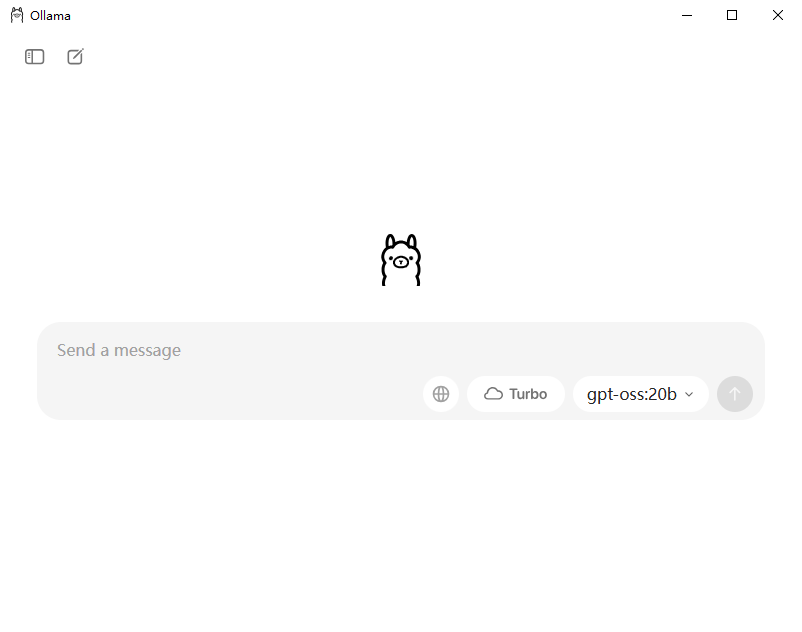

安装完成后,可以看到 Ollama 已经默认运行了。

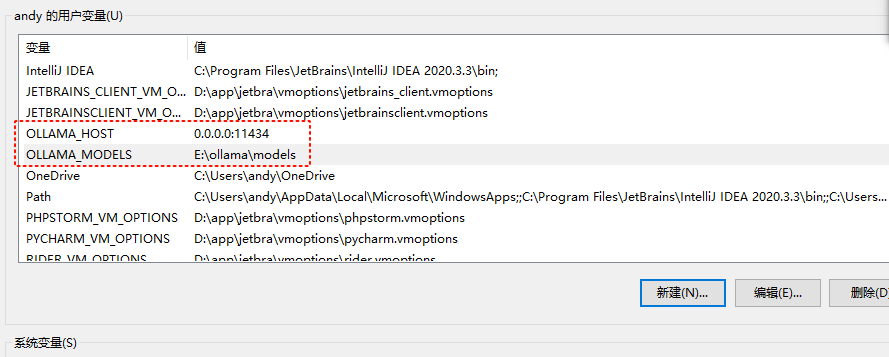

2、配置环境变量

| 参数 | 标识与配置 |

|---|---|

| OLLAMA_MODELS | 表示模型文件的存放目录,默认目录为**当前用户目录**即 C:\Users%username%.ollama\modelsWindows 系统 建议不要放在C盘,可放在其他盘(如 E:\ollama\models) |

| OLLAMA_HOST | 表示ollama 服务监听的网络地址,默认为**127.0.0.1**如果想要允许其他电脑访问 Ollama(如局域网中的其他电脑),**建议设置**成 0.0.0.0 |

| OLLAMA_PORT | 表示ollama 服务监听的默认端口,默认为**11434**如果端口有冲突,可以修改设置成其他端口(如**8080**等) |

| OLLAMA_ORIGINS | 表示HTTP 客户端的请求来源,使用半角逗号分隔列表如果本地使用不受限制,可以设置成星号 * |

| OLLAMA_KEEP_ALIVE | 表示大模型加载到内存中后的存活时间,默认为**5m**即 5 分钟(如纯数字300 代表 300 秒,0 代表处理请求响应后立即卸载模型,任何负数则表示一直存活)建议设置成 24h ,即模型在内存中保持 24 小时,提高访问速度 |

| OLLAMA_NUM_PARALLEL | 表示请求处理的并发数量,默认为**1** (即单并发串行处理请求)建议按照实际需求进行调整 |

| OLLAMA_MAX_QUEUE | 表示请求队列长度,默认值为**512**建议按照实际需求进行调整,超过队列长度的请求会被抛弃 |

| OLLAMA_DEBUG | 表示输出 Debug 日志,应用研发阶段可以设置成**1** (即输出详细日志信息,便于排查问题) |

| OLLAMA_MAX_LOADED_MODELS | 表示最多同时加载到内存中模型的数量,默认为**1** (即只能有 1 个模型在内存中) |

这里主要是配置OLLAMA_HOST和OLLAMA_MODELS两个环境变量。

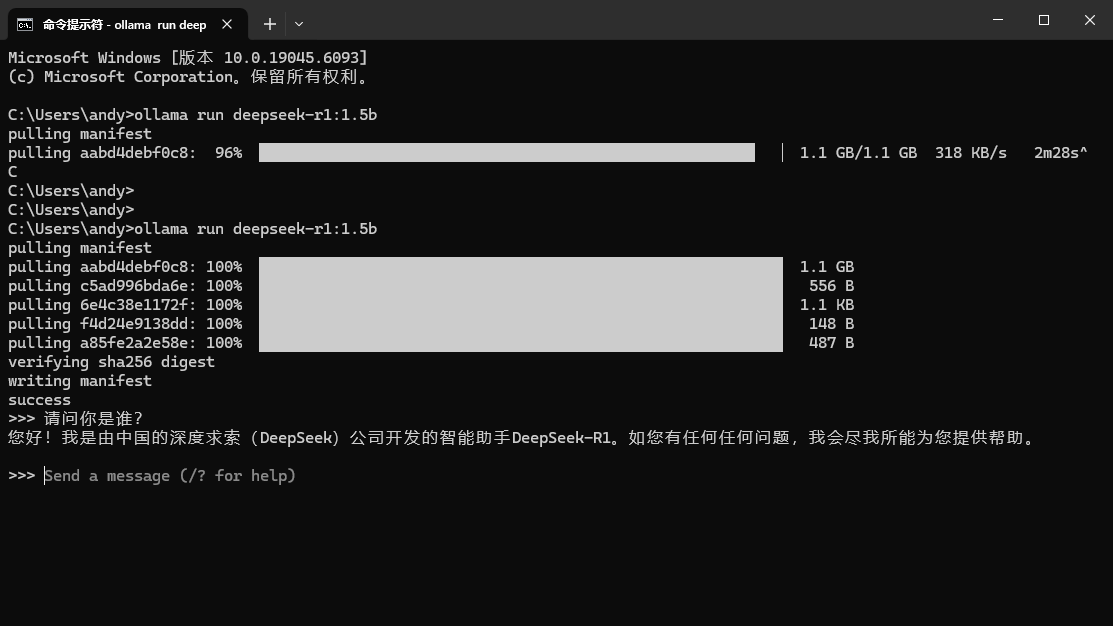

3、下载并运行deepseek大模型

ollama run deepseek-r1:1.5b